AI를 사용하여 로컬 문서 MCP 서버를 배포하고 문서와 채팅하는 방법을 알아보세요.

모델 컨텍스트 프로토콜(MCP)은 Anthropic에서 개발한 개방형 표준입니다. AI 모델이 외부 도구 및 데이터 소스와 상호 작용할 수 있도록 표준화된 인터페이스를 제공합니다. AI 모델은 이 프로토콜을 통해 소프트웨어 도구 및 데이터에 접근할 수 있습니다.이 가이드에서는 dify-docs 저장소를 사용하여 로컬 MCP 서버를 배포하는 방법을 보여줍니다 . 이를 통해 LLM과 문서 간의 자연스러운 소통이 가능해집니다.

MCP 프로토콜에 대한 자세한 내용은 Model Context Protocol 을 참조하세요 .

작동 원리

필수 조건 #

- 노드 ≥ 16.0

- 깃

- MCP 클라이언트(예: Claude Desktop, VS Code 등)

설치 단계 #

1. 복제 저장소 #

Dify 문서 저장소를 로컬로 복제합니다.복사AI에게 물어보세요

git clone https://github.com/langgenius/dify-docs.git

이 저장소는 MCP 서버의 데이터 소스 역할을 합니다.

2. MCP 서버 초기화 #

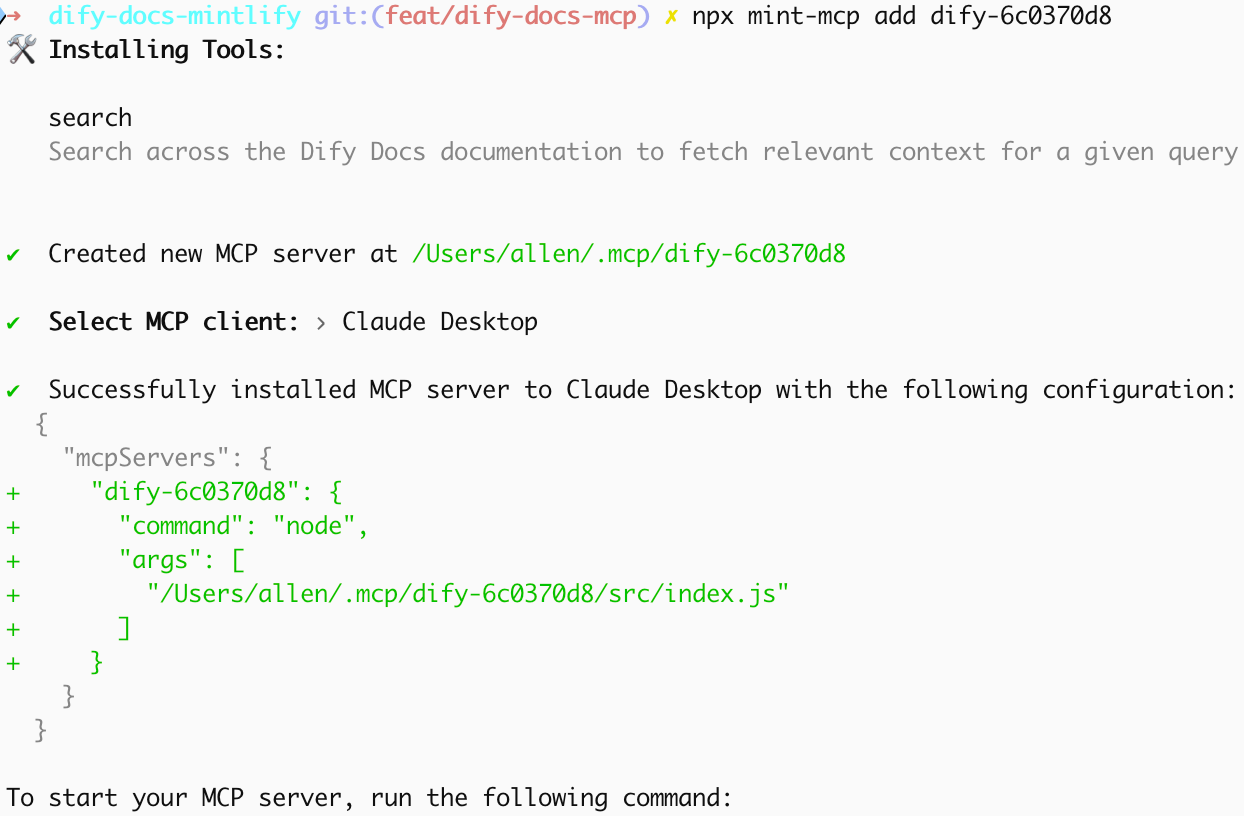

문서 디렉토리로 이동하여 MCP 서버를 설치하세요.복사AI에게 물어보세요

cd dify-docs

npx mint-mcp add dify-6c0370d8

이 명령은 다음 작업을 수행합니다.

- 로컬 MCP 서버 인스턴스를 생성합니다.

- 문서 콘텐츠를 분석하고 색인합니다.

- 필요한 종속성을 구성합니다

설치하는 데는 네트워크 연결 상태에 따라 몇 분 정도 걸립니다.

3. MCP 서버 구성 #

MCP 클라이언트와 서버 관계:MCP 서버는 지식과 도구를 제공합니다. 쿼리 요청을 처리하고, 데이터 리소스를 관리하고, 기능을 실행합니다. 클라이언트는 사용자 인터페이스(일반적으로 AI 애플리케이션이나 채팅 도구)입니다. 클라이언트는 사용자 질문을 받고, MCP 서버로 쿼리를 전달하고, 통합된 응답을 반환합니다.

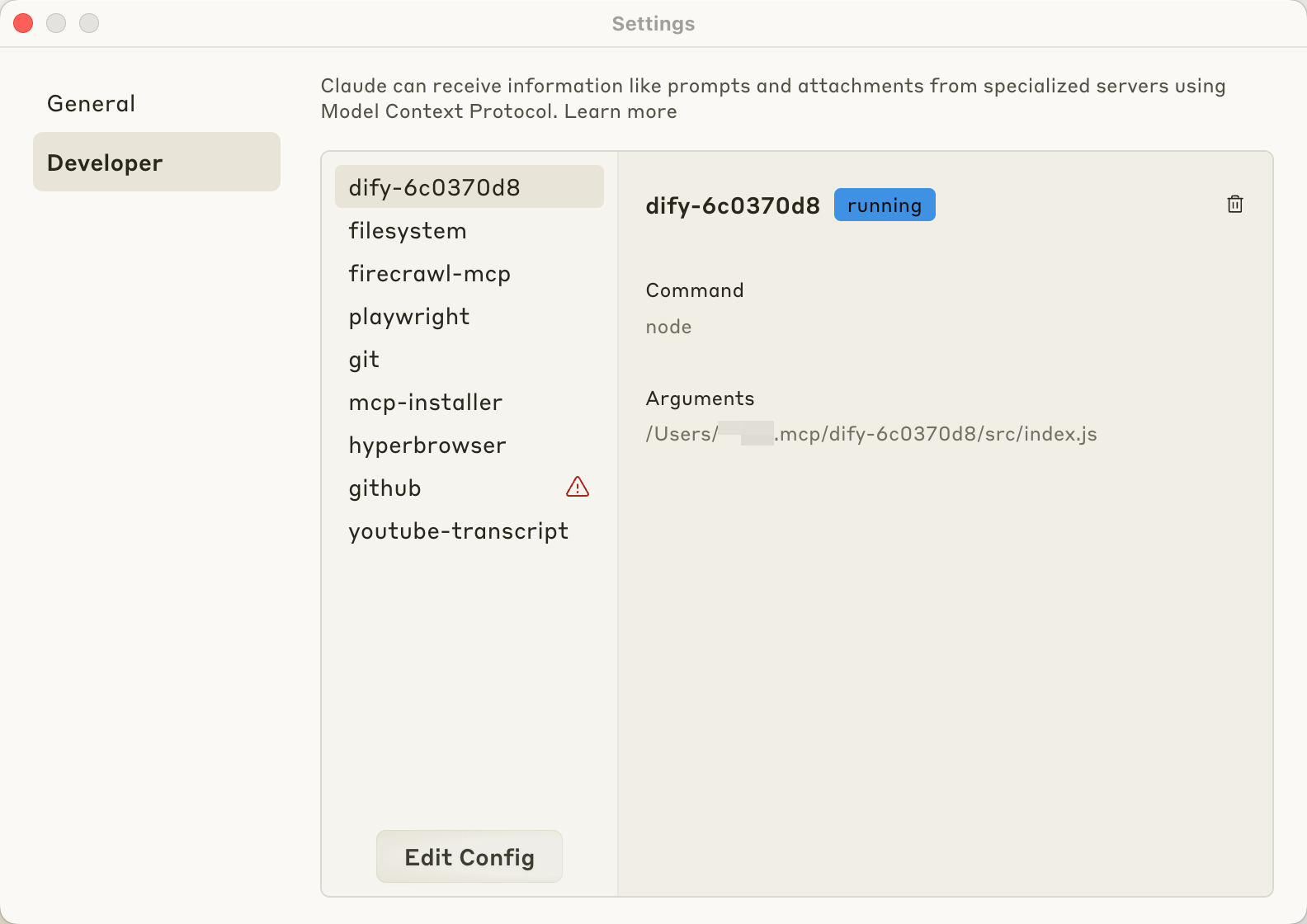

설치 과정에서 MCP 클라이언트를 선택합니다. Claude Desktop을 예로 들면 , 도구가 해당 구성 정보를 생성합니다. 설치가 완료되면 Claude Desktop 설정에서 MCP 서버를 추가하세요. 설정 으로 이동하여 MCP 서버 구성 섹션에 서버 주소와 포트를 추가하고 구성을 저장한 후 애플리케이션을 다시 시작하세요.

설치가 완료되면 Claude Desktop 설정에서 MCP 서버를 추가하세요. 설정 으로 이동하여 MCP 서버 구성 섹션에 서버 주소와 포트를 추가하고 구성을 저장한 후 애플리케이션을 다시 시작하세요.

문서와 대화하기 #

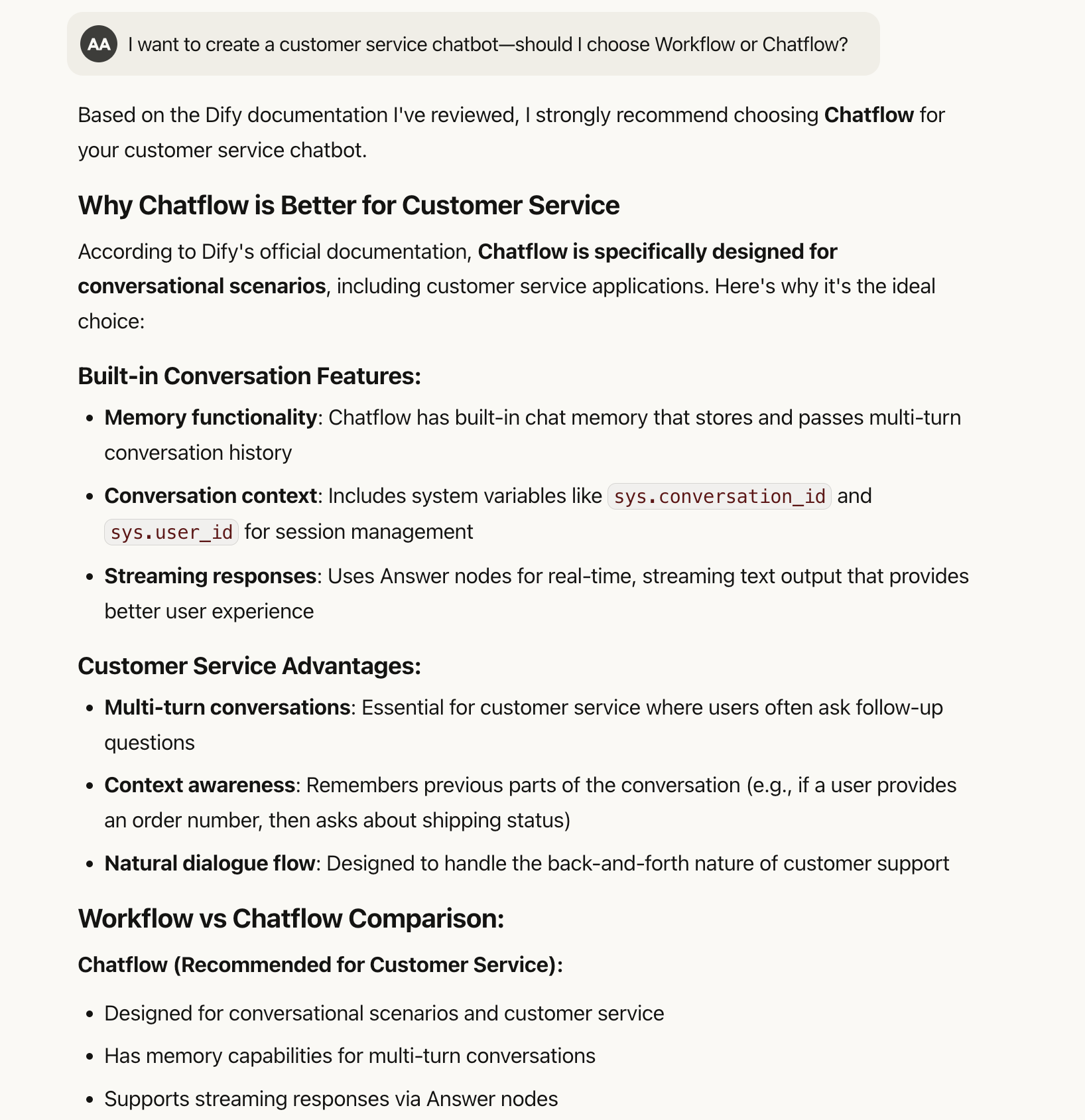

설정이 완료되면 Dify 문서와 소통할 수 있습니다. 자연어 쿼리를 지원하므로 페이지별로 검색하거나 키워드를 정확하게 일치시킬 필요가 없습니다.예를 들어, “고객 서비스 챗봇을 만들고 싶은데 Workflow와 Chatflow 중 어떤 것을 선택해야 할까요?”라고 질문해 보세요. 시스템은 두 옵션의 차이점을 설명하고 고객 서비스 시나리오에 대한 권장 사항을 제공합니다.

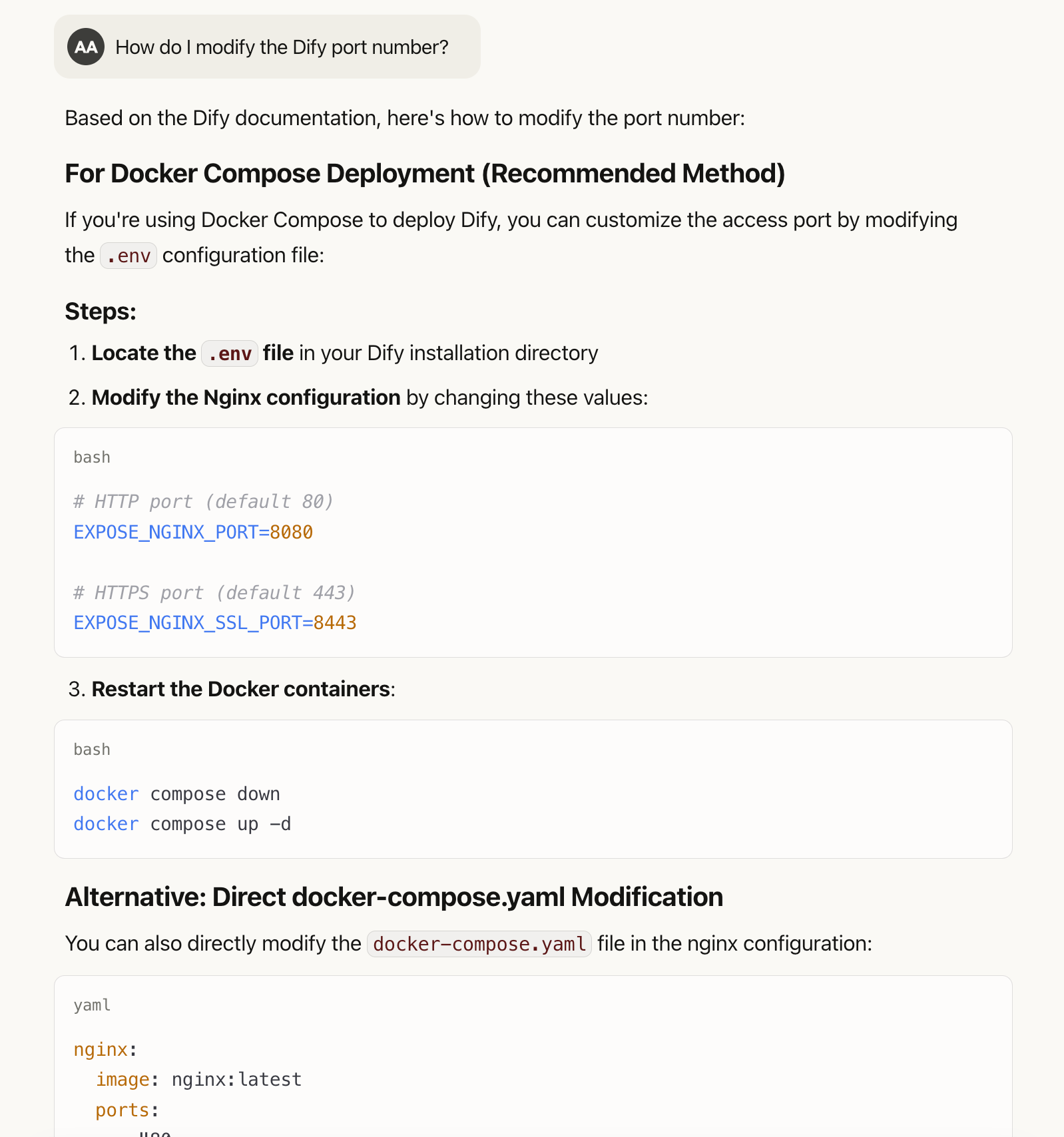

“Dify 포트 번호를 어떻게 수정합니까?”와 같은 기술적인 질문에 대해 AI는 다음과 같은 구체적인 단계를 제공합니다. MCP 방식을 사용하면 문제를 자연어로 설명할 수 있습니다. 특정 기술 용어에 대해 잘 모르더라도 원하는 바를 설명하고 관련 정보를 얻을 수 있습니다.

MCP 방식을 사용하면 문제를 자연어로 설명할 수 있습니다. 특정 기술 용어에 대해 잘 모르더라도 원하는 바를 설명하고 관련 정보를 얻을 수 있습니다.

RAG 방법과의 비교 #

| 특징 | RAG(검색 증강 생성) | MCP(모델 컨텍스트 프로토콜) |

|---|---|---|

| 원칙 | 문서를 텍스트 청크로 분할하고 벡터 임베딩을 사용하여 색인을 구축합니다. 사용자가 질문을 하면 시스템은 질문과 텍스트 청크 간의 유사도를 계산한 후, 관련 청크를 선택하여 답변을 생성합니다. | AI는 질문 요구사항을 기반으로 능동적으로 질의 전략을 생성합니다. 여러 라운드의 대화형 질의를 지원하고 초기 결과에 따라 후속 검색을 조정합니다. |

| 장점 | 빠른 처리 속도로 대규모 정적 문서에 적합합니다. | – 전체 문서 콘텐츠에 액세스할 수 있으며, 장 간 복잡한 쿼리를 지원합니다. – 문서 업데이트 후 복잡한 재처리가 필요 없으며 MCP 서비스를 간단히 재생성합니다. – 일관되고 완전한 답변을 제공합니다. |

| 제한 사항 | – 정적 문서 분할은 관련 정보를 조각낼 수 있습니다. – 벡터 유사성 기반 검색은 의미적으로 관련되지만 어휘적으로 다른 콘텐츠를 놓칠 수 있습니다. – 컨텍스트 창 제한 – 특정 chnks에 따라서만 답변을 생성합니다. | – 상당한 토큰 소모와 더 높은 비용이 필요합니다 . – LLM의 쿼리 전략 생성 기능에 의존하며 검색 정확도에 영향을 미칠 수 있습니다. – 여러 라운드의 대화형 쿼리로 인해 응답 시간이 길어질 수 있습니다. – 추가 MCP 서버 배포 및 유지 관리 비용이 필요합니다. |