워드임베딩 #

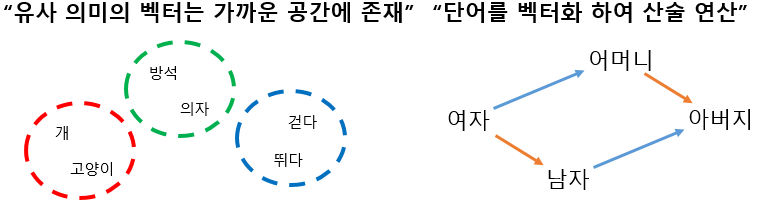

- 사람이 쓰는 자연어를 숫자의 나열인 벡터(vector)로 바꾼 결과 혹은 그 일련의 과정 전체를 가르키는 용어

단어를 숫자로 이루어진 고유한 벡터로 표현. 단어를 벡터로 표현함으로써 다양한 딥러닝 기법을 활용할 수 있는 전기가 마련

통계적으로 어떤 단어들이 서로 가까이에 있는지, 얼마나 유사성이 있는지를 분석할 수 있음

(출처) http://blog.skby.net/%EC%9B%8C%EB%93%9C-%EC%9E%84%EB%B2%A0%EB%94%A9word-embedding/

co-occurrence : 두 개 이상의 어휘가 일정한 범위(range) 혹은 거리(distance) 내에서 함께 출현하는 현상을 말한다. 두 단어가 같이 등장한 횟수가 많아지면 유사한 의미 를 가졌다고 볼 수 있음

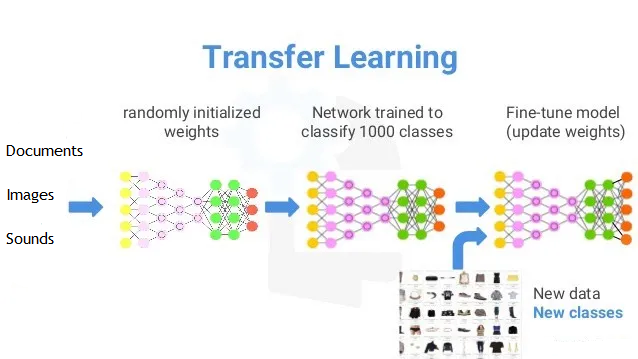

최근 들어 임베딩이 중요해진 이유는 따로 있다. 바로 전이 학습(transfer learning) 때문이다. 전이 학습이란 특정 문제를 풀기 위해 학습한 모델을 다른 문제를 푸는 데 재사용하는 기법을 의미한다. 예컨대 대규모 말뭉치를 미리 학습(pretrain)한 임베딩을 문서 분류 모델의 입력값으로 쓰고, 해당 임베딩을 포함한 모델 전체를 문서 분류 과제를 잘할 수 있도록 업데이트(fine-tuning)하는 방식이 바로 그것

어텐션 메커니즘 #

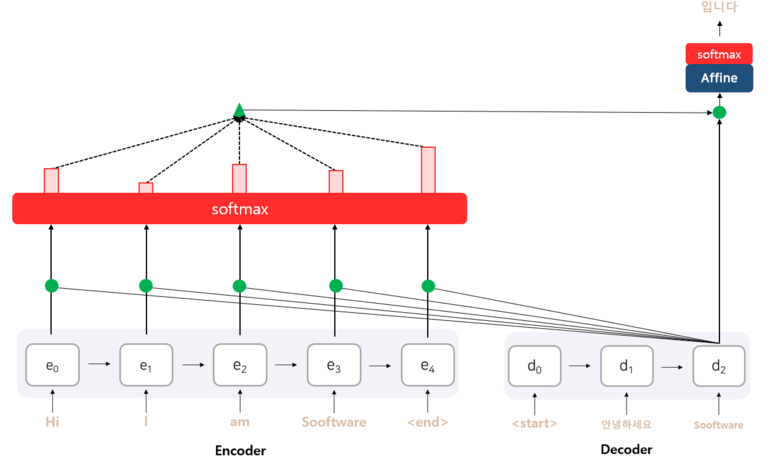

- 어텐션은 입력되는 단어들 간의 연관도를 계산해 문장 시퀀스 출력 시 어디에 더 중점을 둬야 할지를 판단하는 메커니즘.

- 문장 내의 모든 단어가 동일한 중요도를 가지는 것은 아니기 때문에 중요한 단어의 정보만 이용하는 방식

어텐션의 기본 아이디어는 디코더에서 출력 단어를 예측하는 매 시점(time step)마다, 인코더에서의 전체 입력 문장을 다시 한 번 참고한다는 점

단, 전체 입력 문장을 전부 다 동일한 비율로 참고하는 것이 아니라, 해당 시점에서 예측해야할 단어와 연관이 있는 입력 단어 부분을 좀 더 집중(attention)해서 보게 됨

- 디코더의 세 번째 RNN 셀에서 출력 단어를 예측할 때, 어텐션 매커니즘을 사용하는 모습

BERT #

- 단어 간의 연관관계를 학습하는 언어 모델.

- 입력 시퀀스 중간의 일정 부분을 가린 후 가려진 단어를 양방향에서 예측하도록 비지도 사전학습을 진행하는 방식.

- BERT는 문장의 의미를 추출하는 데 강점. 언어 데이터에 라벨이나 어떠한 가공 없이 대량의 말뭉치 학습을 통해 완성시킨 언어 모델로, 타 언어로의 전이가 용이.

- 사전학습이 완료된 모델은 ‘파인튜닝’을 통해 최소한의 구조 변화로 타깃에 쉽게 전이 가능.

BERT(Bidirectional Encoder Representations from Transformers)는 2018년에 구글이 공개한 사전 훈련된 모델

- 위키피디아(25억 단어)와 BooksCorpus(8억 단어)와 같은 레이블이 없는 텍스트 데이터로 사전 훈련된 언어 모델

BERT가 높은 성능을 얻을 수 있었던 것은, 레이블이 없는 방대한 데이터로 사전 훈련된 모델을 가지고, 레이블이 있는 다른 작업(Task)에서 추가 훈련과 함께 하이퍼파라미터를 재조정하여 이 모델을 사용하면 성능이 높게 나오는 기존의 사례들을 참고하였기 때문.

- 다른 작업에 대해서 파라미터 재조정을 위한 추가 훈련 과정을 파인 튜닝(Fine-tuning)

- (Source) modified from https://madhuramiah.medium.com/deep-learning-using-resnets-for-transfer-learning-d7f4799fa863

GPT #

- GPT는 주어진 단어를 통해 다음 단어가 무엇인지 일방향성으로 예측하기 위한 비지도 사전학습 방식.

- 사전학습이 완료된 모델은 ‘파인튜닝’을 통해 최소한의 구조 변화로 타깃에 쉽게 전이 가능.

- BERT에 비해 ‘생성’에 더 강점이 있는 GPT 시리즈는 초거대 인공지능 모델의 경쟁을 촉발시킴.

Generative Pre-trained Transformer 3(GPT-3)는 샌프란시스코에 본사를 둔 인공지능 연구소 오픈AI가 제작한 ‘대형언어모델(large language model)’ 로서 2020년 6월 출시. 사전 훈련된 생성 변환기’(Generative Pre-trained Transformer)

딥러닝(deep learning)을 이용하는 알고리즘으로, 책이나 인터넷에 있는 수많은 텍스트를 학습하여 단어와 구절을 연결해 텍스트를 생성

GPT-3를 만들기 위해서 오픈AI는 GPT-3의 이전 모델인 GPT-2를 만들 때 사용했던 것과 동일한 방법과 알고리즘을 거의 그대로 사용. 차이점이 있다면 GPT-3가 GPT-2보다 훨씬 방대한 신경망(neural network)을 가지고 있으며, 훨씬 거대한 학습 데이터를 사용했다는 점. GPT-3는 1,750억 개의 파라미터(parameter)를 가지고 있는데, GPT-2의 파라미터가 15억 개였던 것과 비교하면 엄청난 차이. GPT-3는 학습할 때도 훨씬 많은 데이터를 사용

ChatGPT #

2022년 11월 30일, GPT3.5 기반 ChatGPT의 베타버전이 공개

ChatGPT is derived from GPT-3, a modern generative AI model based on the Transformer architecture. The transformer architecture is a specific type of neural network invented by Google in 2017.

the cost of running OpenAI’s text-generating GPT-3 — which has around 175 billion parameters — on a single Amazon Web Services instance to be around $87,000 per year.

ChatGPT는 여태까지 진행된 대화 히스토리를 그 다음 답변을 생성할 때 함께 Input으로 넣는 방식으로 이전 대화를 “기억”